In occasione degli scontri del 31 gennaio a Torino, la Polizia di Stato ha condiviso un’immagine raffigurante agenti coinvolti nei disordini, successivamente rilevata come manipolata tramite AI. Questo caso evidenzia le implicazioni dell’uso delle tecnologie di intelligenza artificiale nella comunicazione ufficiale e nelle informazione di pubblica utilità.

- Analisi delle anomalie nelle immagini ufficiali

- Utilizzo di strumenti di riconoscimento AI

- Impatto delle fake news nelle dinamiche di narrazione pubblica

- Questioni etiche sull’autenticità delle fonti

- Misure di limitazione nelle piattaforme social

Dettagli della normativa e implicazioni legali

La diffusione di contenuti falsi tramite AI può configurare reati come la diffamazione o l’uso illecito di immagini. Le autorità stanno valutando misure per contrastare la diffusione di notizie manipolate e garantire l’autenticità delle comunicazioni ufficiali.

Modalità: Controlli su contenuti ufficiali, verifica mediante strumenti digitali avanzati

Approfondisci sul nostro sitoContesto degli scontri e diffusione dell’immagine

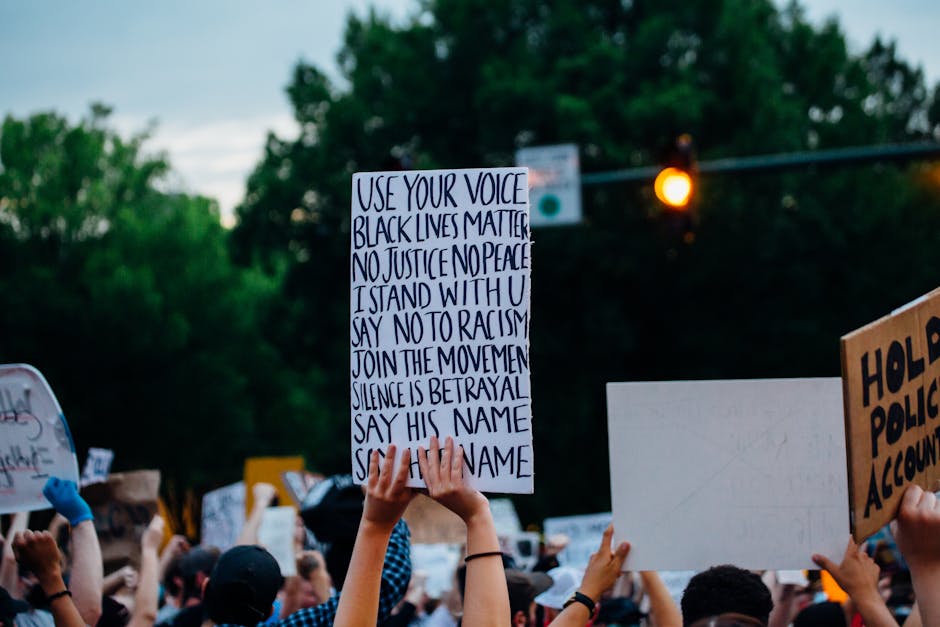

Gli scontri del 31 gennaio a Torino, avvenuti durante una manifestazione contro lo sgombero del centro sociale Askatasuna, hanno rappresentato un momento intenso di tensione tra manifestanti e forze dell'ordine, coinvolgendo circa un centinaio di agenti e numerosi partecipanti alla protesta. In un tentativo di diffondere un’immagine ufficiale degli agenti coinvolti, la Polizia ha pubblicato sui canali social una fotografia che ritraeva due agenti, Alessandro Calista e Lorenzo Virgulti, con l’obiettivo di mostrare il volto delle forze dell’ordine e di sostenere la versione ufficiale degli eventi. Tuttavia, nei giorni successivi, diverse analisi e interventi di esperti di digital forensics hanno evidenziato come la stessa immagine fosse stata manipolata attraverso tecniche di intelligenza artificiale o di fotoritocco, rendendo i volti e alcuni dettagli delle divise non completamente autentici. Questa scoperta ha alimentato un dibattito sui rischi di disinformazione e sulle responsabilità delle istituzioni nel diffondere contenuti verificati, soprattutto in situazioni di allerta sociale. La diffusione di immagini alterate può minare la fiducia pubblica nelle comunicazioni ufficiali e complicare la comprensione dei fatti, creando confusione tra cittadini e media.

Dettagli della normativa e implicazioni legali

Inoltre, la normativa vigente prevede sanzioni specifiche per chi divulga immagini o notizie false, in particolare quando queste possono causare danni all’immagine di persone o istituzioni, o quando veicolano informazioni ingannevoli che incidono sulla sicurezza pubblica. Nel contesto degli scontri a Torino, l’utilizzo di immagini modificate attraverso l’intelligenza artificiale da parte delle forze dell’ordine o di terzi potrebbe essere soggetto a verifiche approfondite per accertare eventuali violazioni di legge. Le implicazioni legali si estendono anche alla tutela della privacy e alla responsabilità per la diffusione di contenuti manipolati, che potrebbe coinvolgere sia chi produce che chi condivide queste immagini. La legge attribuisce inoltre una particolare attenzione alle misure di trasparenza e ai procedimenti adottati dalle autorità, per evitare abusi e garantire che le comunicazioni siano sempre affidabili e verificabili. In tale contesto, le autorità stanno rafforzando i controlli e la collaborazione con esperti di cybersecurity e diritto digitale, con l’obiettivo di creare un quadro normativo efficace per contrastare la diffusione di informazioni manipolate e tutelare i cittadini contro le fake news e le pratiche ingannevoli.

Quali elementi presentano anomalie evidenti

Durante l’analisi delle immagini rilasciate in relazione agli scontri a Torino, sono emerse diverse anomalie che indicano possibili alterazioni o manipolazioni digitali. In primo luogo, alcuni segni o decorazioni sui caschi appaiono privi di senso logico, perché inseriti senza coerenza con il contesto o con le caratteristiche tipiche di tali equipaggiamenti. Questi dettagli inconsistenti possono tradursi in evidenti errori di digitazione o di design, suggerendo una modifica successiva all’immagine originale.

Inoltre, le rappresentazioni delle lettere sulle divise degli agenti risultano imperfette e spesso sgranate, come se fossero state modificare con strumenti di editing non professionali. La mancanza di dettagli nitidi può indicare una composizione non accurata o la sovrapposizione di elementi digitali artificiosi. Altra anomalia degna di nota è l’assenza di alcuni elementi riconoscibili, come gli scudi o le mascherine, che normalmente sono presenti sul personale delle forze dell’ordine in situazioni di scontri di questa natura. Questa mancanza potrebbe essere il risultato di una manipolazione volta a semplificare o cambiare la percezione della scena.

Infine, si osservano modifiche digitali nello sfondo degli scatti ufficiali: elementiambientali come strutture, veicoli o addirittura il cielo sembrano alterati. Questi cambiamenti potrebbero essere stati effettuati con lo scopo di nascondere certi dettagli o di creare una rappresentazione più diffusa e performante rispetto alla realtà. La presenza di queste anomalie evidenzia l’importanza di un'analisi accurata delle immagini ufficiali e sottolinea come tecnologie avanzate come l’intelligenza artificiale possano essere usate anche per manipolare informazioni in modo subdolo e potenzialmente diffamatorio o fuorviante.

Come sono state identificate le alterazioni

Le autorità e le forze dell'ordine hanno anche confrontato le immagini con evidenze raccolte sul campo durante gli Scontri a Torino, oltre ad analizzare le tracce digitali associate. Questa procedura ha consentito di verificare la provenienza e l’attendibilità del materiale, evidenziando come l’immagine diffusa dalla Polizia fosse stata alterata tramite tecniche avanzate di intelligenza artificiale. La combinazione tra analisi automatizzata e indagini tradizionali ha permesso di identificare con precisione le manipolazioni e di scoraggiare la diffusione di informazioni false o fuorvianti sui social media. Tutto ciò sottolinea l’importanza di strumenti tecnologici di ultima generazione nel contrasto alla disinformazione, soprattutto durante eventi critici come gli Scontri a Torino. Inoltre, l’uso di AI ha facilitato un’indagine più rapida e accurata, contribuendo a mantenere un quadro più chiaro degli avvenimenti e a garantire la trasparenza dell’operato delle forze dell’ordine.

Conseguenze immediate e risposta delle piattaforme

In seguito alle verifiche, Facebook e Instagram hanno applicato etichette di avviso sulla presenza di potenziali fake news. La limitazione della visibilità dell’immagine ha rappresentato un passo importante per evitare la diffusione di informazioni fuorvianti.

Impatti sulla fiducia nei contenuti ufficiali

La vicenda mette in discussione le modalità di comunicazione delle forze dell’ordine e solleva quesiti sull’utilizzo delle tecnologie AI per la creazione e diffusione di contenuti ufficiali, richiedendo regolamentazioni più stringenti e strumenti di verifica più efficaci.

FAQs

Scontri a Torino: la Polizia ha diffuso un’immagine alterata con l’intelligenza artificiale

Per poter mostrare un’immagine ufficiale degli agenti coinvolti negli scontri, ma è stata successivamente scoperta come manipolata tramite tecniche di intelligenza artificiale.

Attraverso analisi di digital forensics, confronti sul campo e strumenti avanzati di riconoscimento AI, che hanno evidenziato anomalie come dettagli sgranati e incoerenze visive.

Segni incongruenti su caschi, lettere sgranate sulle divise, assenza di elementi riconoscibili come mascherine e alterazioni negli sfondi sono state evidenziate come possibili manipolazioni.

Può minare la fiducia pubblica nelle comunicazioni ufficiali, diffondere disinformazione e creare confusione tra cittadini e media, compromettendo la credibilità delle fonti istituzionali.

Facebook e Instagram hanno applicato etichette di avviso e limitato la visibilità dell’immagine per fermare la diffusione di potenziali fake news.

Le sanzioni previste possono includere multe e responsabilità penali per chi diffonde contenuti falsi, con particolare attenzione alla tutela della privacy e dell’integrità delle fonti ufficiali.

Hanno permesso di verificare la provenienza dell’immagine e di identificare manipolazioni tramite confronti con evidenze raccolte sul campo e strumenti tecnologici avanzati.

Possono alterare la percezione dei fatti, fomentare tensioni, o creare confusione tra manifestanti e forze dell’ordine, complicando la comprensione della situazione reale.

L’AI può essere usata per creare immagini realistiche ma false, alterando dettagli o creando scene che non sono mai avvenute, con rischi di diffusione di informazioni ingannevoli.